人工智能安全治理-《人工智能安全治理框架》1.0版解读

《人工智能安全治理框架》1.0版 解读

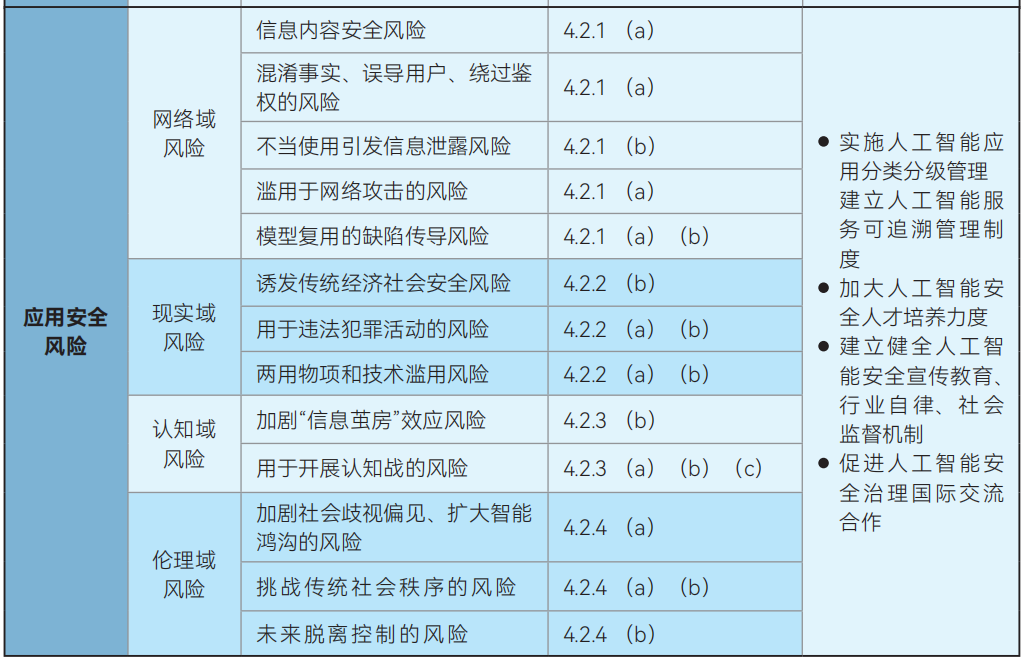

安全风险与技术应对措施、综合治理措施映射表

站在使用AI的公司的角度

安全风险

主要有以下几个风险。

数据安全风险:

- 违规收集使用数据风险:人工智能训练数据的获取,以及提供服务与用户交互过程中,存在未经同意收集、不当使用数据和个人信息的安全风险。

- 数据泄露风险:人工智能研发应用过程中,因数据处理不当、非授权访问、恶意攻击、诱导交互等问题,可能导致数据和个人信息泄露。

系统安全风险:

- 缺陷、后门被攻击利用风险:人工智能算法模型设计、训练和验证的标准接口、特性库和工具包,以及开发界面和执行平台可能存在逻辑缺陷、漏洞等脆弱点,还可能被恶意植入后门,存在被触发和攻击利用的风险。

网络域风险:

- 不当使用引发信息泄露风险:政府、企业等机构工作人员在业务工作中不规范、不当使用人工智能服务,向大模型输入内部业务数据、工业信息,导致工作秘密、商业秘密、敏感业务数据泄露。

技术对应措施

数据安全风险:

应对违规收集使用数据风险:在训练数据和用户交互数据的收集、存储、使用、加工、传输、提供、公开、删除等各环节,应遵循数据收集使用、个人信息处理的安全规则,严格落实关于用户控制权、知情权、选择权等法律法规明确的合法权益。

应对数据泄露风险:

- ①对训练数据进行严格筛选,确保不包含核生化导武器等高危领域敏感数据。

- ②训练数据中如包含敏感个人信息和重要数据,应加强数据安全管理,符合数据安全和个人信息保护相关标准规范。

系统安全风险:

- 应对缺陷、后门被攻击利用风险:

- ①对人工智能技术和产品的原理、能力、适用场景、安全风险适当公开,对输出内容进行明晰标识,不断提高人工智能系统透明性。

- ②对聚合多个人工智能模型或系统的平台,应加强风险识别、检测、防护,防止因平台恶意行为或被攻击入侵影响承载的人工智能模型或系统。

综合治理措施

应对数据安全风险中的违规收集使用数据风险和数据泄露风险:

- 完善人工智能数据安全和个人信息保护规范:针对人工智能技术及应用特点,明确人工智能训练、标注、使用、输出等各环节的数据安全和个人信息保护要求

应对系统安全风险的缺陷、后门被攻击利用风险:

- 人工智能安全风险威胁信息共享和应急处置机制:持续跟踪分析人工智能技术、软硬件产品、服务等方面存在的安全漏洞、缺陷、风险威胁、安全事件等动向,协调有关研发者、服务提供者建立风险威胁信息通报和共享机制。构建人工智能安全事件应急处置机制,制定应急预案,开展应急演练,及时快速有效处置人工智能安全威胁和事件。

应对网络域风险中的不当使用引发信息泄露风险:

- 在使用人工智能产品前,应全面了解其数据处理和隐私保护措施

- 使用高安全级别的密码策略,启用多因素认证机制,增强账户安全性

- 增强网络安全、供应链安全等方面的能力,降低人工智能系统被攻击、重要数据被窃取或泄露的风险,保障业务不中断。

- 合理限制人工智能系统对数据的访问权限,制定数据备份和恢复计划,定期对数据处理流程进行检查。

- 确保操作符合保密规定,在处理敏感数据时使用加密技术等保护措施

原文地址

https://mp.weixin.qq.com/s/vaFo4eMqHA_U0WFPhJEFcQ

https://www.tc260.org.cn/front/postDetail.html?id=20240909102807

pdf下载地址:

人工智能安全治理框架(中文版).pdf:

https://www.tc260.org.cn/upload/2024-09-09/1725849142029046390.pdf

人工智能安全治理框架(英文版).pdf:

https://www.tc260.org.cn/upload/2024-09-09/1725849192841090989.pdf